AI분야에서 거의 모든 분야에서 Transformer모델이 널리 적용되고 있습니다.

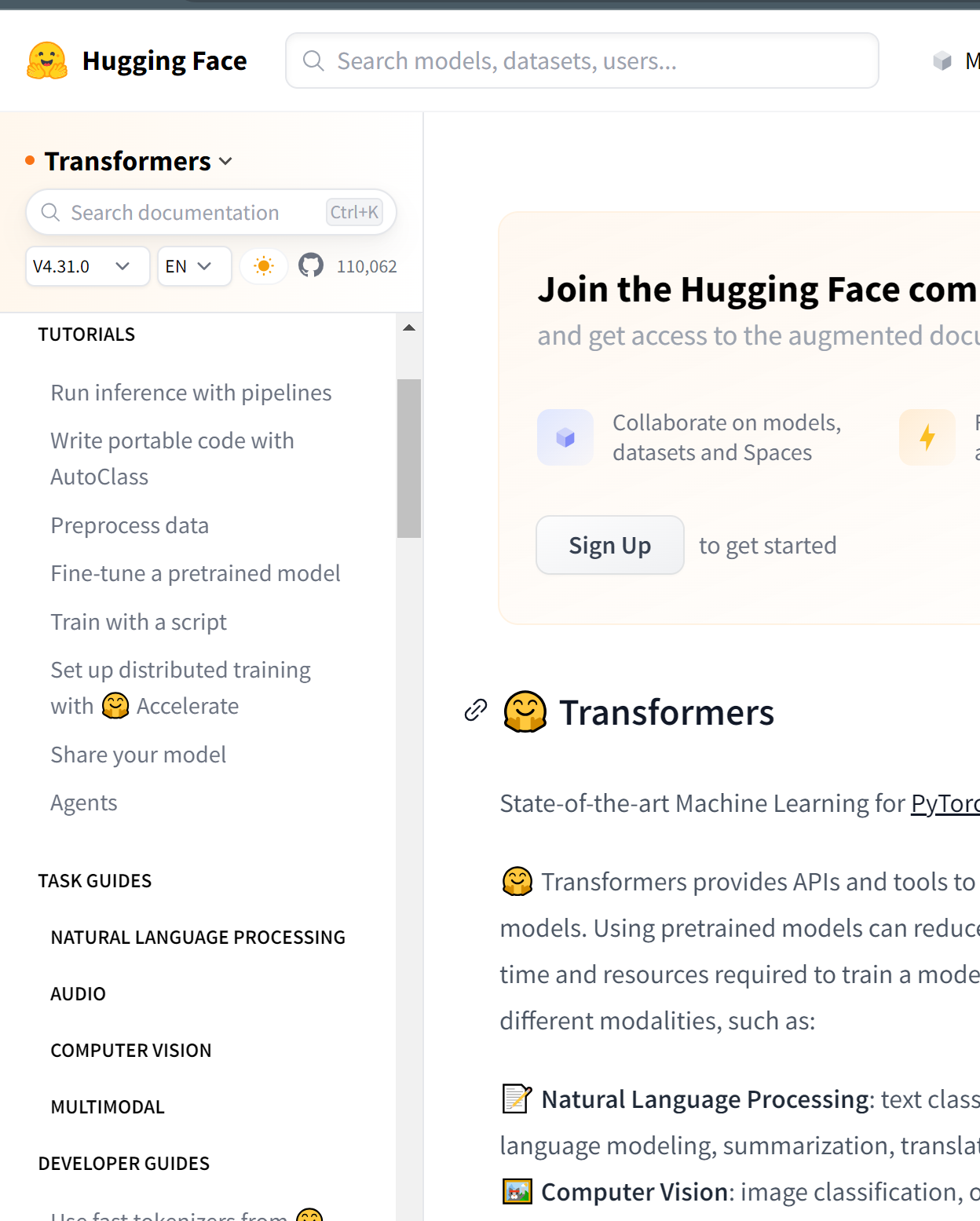

HugginfFace 에서는 Transformer 라이브러리를 제공하고 있으며,

이를 통해 다양한 Pretrained 모델을 Fine Tunning할 수 있는 코드를 소개하고 있습니다.

https://huggingface.co/docs/transformers/index

🤗 Transformers

Reinforcement learning models

huggingface.co

튜토리얼의 내용을 보면 간단합니다.

1. 추론(inference)은 다단계를 거쳐(pipelines) 활용 가능합니다.

2. 라이브러리를 통해 쉽게 구현할 수 있습니다.

3. 물론 제일 중용한 것은 데이터의 준비입니다. 아마도 이 부분이 제일 많은 작업을 필요로 할 것입니다.

4. 기존의 Pretrained 모델을 Fine튜닝합니다. 인프라적인 요소입니다. 많은 비용이 필요할 수 있습니다. 빅모델에 따라 GPU용량도 큰 것을 필요로 합니다. 그에 따라 비용도 증대되고 있습니다.

5. FineTuning하는 과정(Training)을 Script로 공개되어 있습니다. 간단하게는 10줄이 안됩니다.

6. 새롭게 튜닝한 모델을 공유하는 체계를 소개하고 있습니다.

그 다음은 각 미디어 또는 분야별로 자세히 설명하고 있습니다.

1. NLP : 글자 데이터 처리

2. Audio : 음성 데이터 처리

3. Computer Vision : 영상 데이터 처리.

4. MultiModal : 동영상 데이터 처리..

Transformer 모델에 대한 기술적 요소는 아래에 잘 정리되어 있습니다.

Transformer 분석(2): Transformer의 Encoder 이해하기 | by daewoo kim | Medium

Transformer 분석(2): Transformer의 Encoder 이해하기

Transformer Encoder의 구조에 대해서 알아보자…

moon-walker.medium.com

https://arxiv.org/abs/1706.03762

Attention Is All You Need

The dominant sequence transduction models are based on complex recurrent or convolutional neural networks in an encoder-decoder configuration. The best performing models also connect the encoder and decoder through an attention mechanism. We propose a new

arxiv.org

16-01 트랜스포머(Transformer)

* 이번 챕터는 앞서 설명한 어텐션 메커니즘 챕터에 대한 사전 이해가 필요합니다. 트랜스포머(Transformer)는 2017년 구글이 발표한 논문인 Attention i…

wikidocs.net

https://theaisummer.com/transformer/

How Transformers work in deep learning and NLP: an intuitive introduction | AI Summer

An intuitive understanding on Transformers and how they are used in Machine Translation. After analyzing all subcomponents one by one such as self-attention and positional encodings , we explain the principles behind the Encoder and Decoder and why Transfo

theaisummer.com

'IT' 카테고리의 다른 글

| [정의] Crawl Depth (0) | 2023.10.13 |

|---|---|

| [ 도메인 관리 ] wildcard subdomain, 가비아 (0) | 2023.09.08 |

| Top 10 안드로이드 앱 feat. 인공지능 artificial intelligence - 2023 (0) | 2023.04.16 |

| [기계번역-신경망기반 엔진] DeepL Translator (0) | 2023.03.01 |

| 드디어 (나의) 티스토리 블로그, 구글 검색 연결 성공! & adsense 연동 성공 (0) | 2023.02.09 |