국내 대표 기술 기업인 네이버는 초거대 AI 모델 '하이퍼클로바X‘와 생성형 AI 서비스 '큐(CUE)'를 준비 중이며,챗GPT에 대한 방송 기사가 공중파 방송 및 공중파 라디오까지 언급되는 것을 보면,

인공지능 기술이 일반(public)인에게도 영향이 있을 정도인가 봅니다.

근데, 방송 및 신문기사에서는 해당 분야 기술자들이나 외국에서 쓰는 용어와 다르게 표현하고 있습니다.

초거대 AI 라는 용어를 쓰고 있는데, 영어 및 해당 기술분야에서는 LLM(Large Language Model)입니다.

언어모델(Language Model)이라고 하면, 어필이 좀 덜 되는 측면이 있고, 전달력도 낮을 것 같긴합니다. 그래서 그냥 AI(인공지능)이라고 조금 더 상위의 것을 사용하고 있습니다. 또한 영어에서는 Large인데, 너무 크게 과대 포장(?)하어 초거대라고 지칭하고 있습니다.

OpenAI사도 GPT나 ChatGPT는 LLM으로 소개하고 있습니다. 언어모델(LM)이라는 것은 문장을 생성(Generative)하는 네크워크를 의미합니다. 그 네트워크를 쫓아가면 문장이 생성되죠. 차를 타고 도로를 경유하면 서울-대전-대구-부산이 되듯이. 물론 신경망이 되면서 2차원적인 경로 탐색의 문제를 넘어서죠...

또는 "아버지" 상태에서 뒤쪽에 커서가 깜박거리면, 다음 글자가 뭐가 될까요?

"아버지" 뒤에 띄어쓰기가 오면, 이후에는 전반적으로 "아버지 가방에 들어가신다"가 될 것이고,

"아버지가" 가 되면, 이후에는 전반적으로 "아버지가 방에 들어가신다"가 됩니다.

즉 "아버지" 뒤에 무엇이 올지를 확률적 또는 신경망 기반으로 모델링하게 되고, 높은 확률(낮은 엔트로피)개념으로 그 다음 문자들이 만들어지고, 문자는 단어(어절)을, 단어(어절)은 문장을 만들게 되죠..

위의 간단한 예지만 큰 LM에서는 어마어마한 문장을 생성할 수 있게 됩니다.

텍스트 생성 및 챗봇AI 지형도... 10개 커테고리서 700여 기업 경쟁..

맨 하단의 Language Models 커테고리에 GPT-4, BERT, ELECTRA 등이 존재하네요.

2023년 5월 12일 추가 작성.

구글이 바드(bard) 한국어 서비스를 제공. 구글은 기존의 람다(LaMDA) 대신에 팜2(PaLM2)으로 대체하였다. 100여개 언어를 지원한다. OpenAI의 ChatGPT보다 성능이 우수하고, 출처 표기 기능 등 새로운 기능도 탑재하겠죠.

네이버는 올 여름 '하이퍼클로바X'를 공개할 예정이고, 카카오도 '코지피티(koGPT)'를 준비 중입니다.

2023년 7월 22일 추가 작성.

22년 11월에 OpenAI 로부터 ChatGPT가 나오고, 본 블로그가 23년 2월에 최초 작성되고 약 6개월이 지난 시점입니다.

여전히 국내에서는 관련 서비스가 나오고 있지 않죠..

https://www.techm.kr/news/articleView.html?idxno=112412

빅테크 '거대 언어 모델' 전쟁 속…韓 기업들 "기술력으로 차별화" - 테크M

\'챗GPT\' 열풍으로 촉발된 빅테크들의 \'거대 언어 모델(LLM)\' 경쟁이 날로 치열해지고 있다. 시장 선점에 나선 마이크로소프트에 이어 경쟁자 구글이 따라 붙었고, 이어 페이스북, 아마존은 물론

www.techm.kr

의 23년 7월 20일 날짜의 기사를 요약해 봅니다.

네이버 이고요,

국내 대표 기술 기업인 네이버는 초거대 AI 모델 '하이퍼클로바X‘와 생성형 AI 서비스 '큐(CUE)'를 준비 중이며,

카카오 이고요,

카카오도 AI 전문 자회사 카카오브레인을 통해 최근 '칼로2.0' 공개한 데 이어 초거대 AI '코(KO)GPT 2.0'을 내놓을 예정이다.

LG연구원이고요,

이에 앞서 지난 20일 AI 분야를 구광모 회장이 점찍은 새로운 성장동력으로 키우고 있는 LG가 초거대 멀티모달 AI '엑사원 2.0'을 공개하며 주목을 받았다. 엑사원은 국내 최초로 텍스트와 이미지를 양방향으로 생성 가능한 멀티모달 모델과 영어와 한국어를 이해하는 이중언어 모델을 동시에 상용화했으며, 2.0 모델에선 기존 모델 대비 학습 데이터를 4배 이상 늘렸다.

스타트업 업스테이지 이고요,

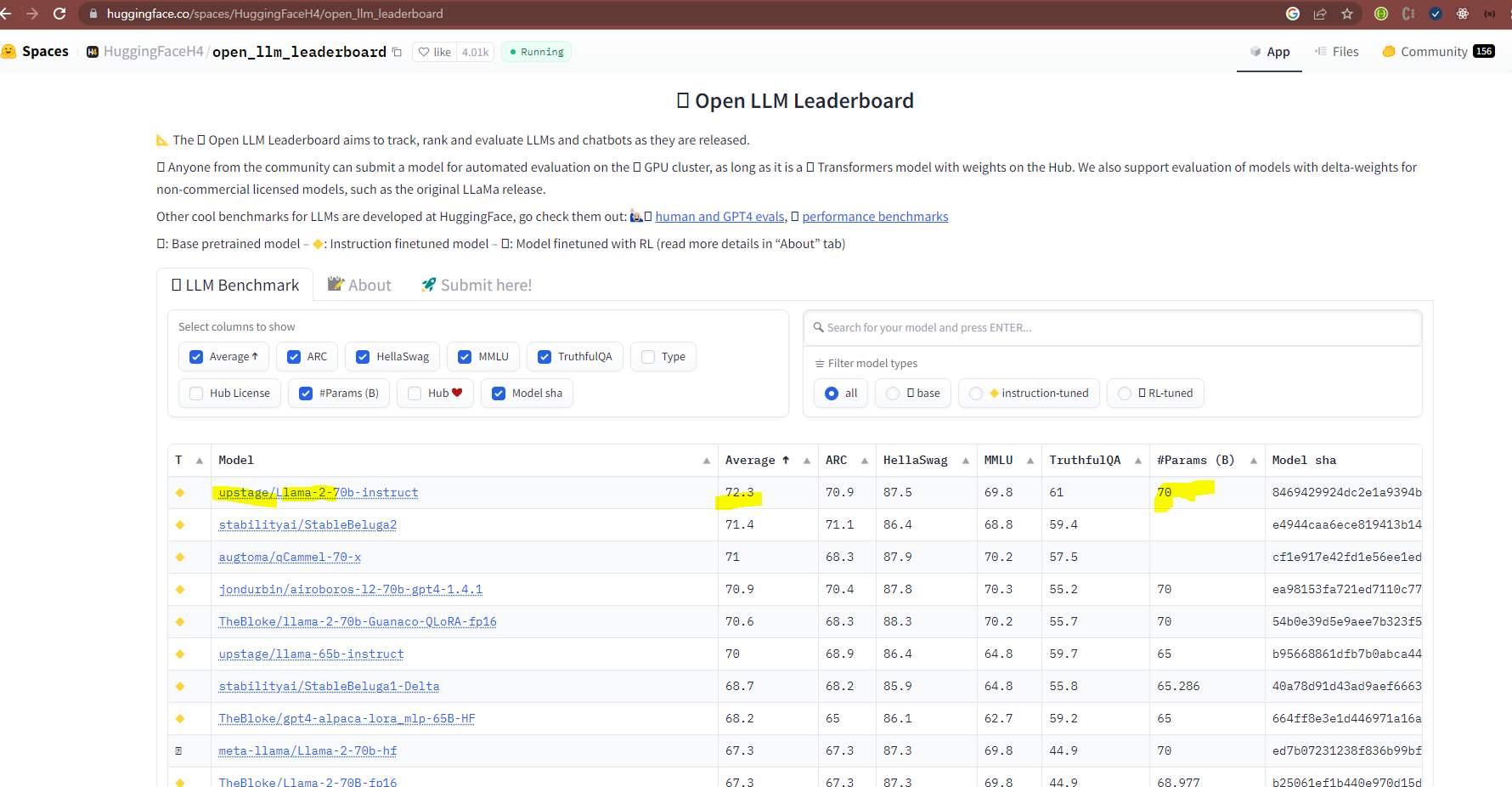

최근 AI 스타트업 업스테이지는 글로벌 AI 플랫폼인 '허깅페이스'의 오픈 LLM 성능 평가에서 페이스북의 '라마2'를 누르고 1위를 차지해 업계를 놀라게 했다. 업스테이지의 모델은 라마2 모델의 절반 규모의 파라미터에도 불구하고 더 우수한 성능을 발휘해 향후 프라이빗 AI 시장에서 두각을 나타낼 것이란 기대감을 키웠다.

코난테크놀로지 (feat. SK텔레콤) 이고요,

SK텔레콤의 전폭적 지원을 받고 있는 코난테크놀로지도 자체 개발 거대 언어 모델 '코난 LLM' 출시에 박차를 가하고 있다. 코난코난테크놀로지는 13.1B 파운데이션 모델의 파인튜닝을 거쳐 다음달 정식 출시할 예정이다. 코난 LLM은 온프레미스 제공으로 생성형 AI의 보안과 기밀유출 우려를 방지하고 B2B, B2G향 초거대 AI를 표방하는 점이 특징이다. 특히 코난 LLM은 특정 기업의 API나 오픈소스 기반이 아닌 자체 개발된 생성형 언어 모델로 차별화를 꾀한다.

종합하면, 몇 개월 전도 계획이었고, 현재도 "예정", "준비중", "기존 업그레이드", "경량화" 입니다.

용어도 대기업 등은 "초거대"라는 용어를 사용하고 있고 스타트업이나 벤처기업은 "거대 언어모델" 또는 "LLM"이라는 용어를 사용하네요.

2023년 8월 2일 추가 작성.

스타트업 업스테이지의 결과를 허깅페이스의 리더보드에 공개되어 있네요.

Rank 1이 맞습니다. 파라미터는 70B개이고요. Llama-2를 파인튜닝(fine-tunning)한 모델입니다.

조금 더 자세히 들여다보면, ( https://huggingface.co/upstage/Llama-2-70b-instruct )

- LLaMa-2 가 백본이고, 영어입니다. Transformer기반이고요. 모델이 커서 실시간 API 데모는 안됩니다.

- 파인튜닝 데이터는 Orca-style dataset 만을 사용하였다고 합니다.

- A100 80GB GPU에서 테스트되었고요.

- 토큰 크기는 대략 10K+, 만 여개입니다.

- 훈련에 A100x8 *4 라고 되어 있습니다.

- 훈련속도를 개선하기 위해, DeepSpeed 라이브러리와 HuggingFace Trainer 및 Accelerate를 사용하였다고 합니다.

2023년 8월 11일 추가 작성.

HuggingFace는 Transformer 라이브러리를 제공하고, Pytorch 및 Tensorflow 기반의 여러 서비스 모델에 대한 예시문들을 보여 주고 있습니다. 예를 들면,

https://github.com/huggingface/transformers/tree/main/examples/tensorflow/language-modeling는 tensorflow로 language모델을 만드는 예시입니다.

언어모델의 특성을 조금 분류를 하면,

| causal language model | masked language model |

| GPT | BERT |

| - | train more quickly and perform better when fine-tuned on a new tasks |

| text generation | text classification |

Causal System은 과거와 현재를 기반으로 현재를 파악하는 것이니, 문장생성과 같이 왼쪽 정보(과거)를 가지고 현재의 정보를 생성하는 것에 적합할 것이고,

Masked 접근은 문장 중에 특정 위치에 있는 것을 마스킹 처리한 것이니, 이미 왼쪽(과거), 오른쪽(미래)의 것을 기반으로 Mask된 것을 추정(Infer)하는 것이니 문맥이나 분류 등에 더 유리할 수 있을 것입니다.

2023년 9월 6일 추가 작성

8월 중순 이후에 크게 2개가 publish 된 것 같습니다.

우선 8월 17일에, 코난테크놀로지가 LLM을 자체적으로 만들고, 그 투입 개발 비용(100억)과 토큰, 파라미터 갯수 까지 밝히면서 기술 발표회를 가졌다. 매스컴의 보도를 그렇게 많이 타지는 못했다.(역시 중소기업의 한계). 아직 일반 사용자의 성능 평가 의견은 없는 것 같다. 자연어처리 관련하여 가장 많은 깨끗한 데이터를 가지고 있는 것 같습니다. 또는 조달 능력을 보유하였거나.

이에 비해 네이버는 방송 미디어에 기사가 나올 정도로 반응은 있었죠. 성능은 구글도 실패한 적이 있었기 때문인지 네이버도 오픈은 하였지만(너무 늦게 출시하면 좀 이상하죠..) 성능은 이슈가 좀 있었던 것 같습니다.

최근에는 sLLM 으로 small LLM 이라는 용어가 고유명사화 되고 있습니다. 조금 이상하죠.. Large 인데 그 앞에 small이라고 합니다. sLM도 아니고.... 예전에는 도메인 특화 또는 Fine-Tunning이라고 한 것 같은데, sLLM이라는 또 다른 용어/접근법이 생겼는가 봅니다.

'IT' 카테고리의 다른 글

| [기계번역-신경망기반 엔진] DeepL Translator (0) | 2023.03.01 |

|---|---|

| 드디어 (나의) 티스토리 블로그, 구글 검색 연결 성공! & adsense 연동 성공 (0) | 2023.02.09 |

| 한국 통신 3사의 챗GPT 파도 타기 (0) | 2023.02.07 |

| OpenAI가 말하는 챗GPT(ChatGPT) 제약점(limitations)는? (0) | 2023.02.01 |

| nouveau driver Disable 진행 (0) | 2023.01.30 |